ニュース

次期OS「Android P」は,AIを使ったサービスやアプリを大幅に拡充。Google I/O基調講演レポート

|

本稿では,講演の概要を簡単にまとめてみよう。

最新のAI技術をサービスに落とし込むGoogle

|

Pichai氏は,医療やアクセシビリティの分野でのAIの事例を紹介しつつ,AIが世界に与えるインパクトや,その成果を説明した。その1つとして披露されたのが,「議論が白熱し,相手の声にかぶせて反論する」というテレビ番組の1シーンから,話者2人の声をそれぞれ分離したうえで,1人ずつ再生して音声認識でテキスト化するというデモである。AIベースの音声認識技術は,同時に聞こえる異なる話者の声まで認識する能力を備えているというわけだ。

|

|

GoogleのAI技術は,エンドユーザー向けのアプリでも使われている。その1つとして取り上げられたのが,メールサービス「Gmail」の新機能である「Smart Compose」だ。

Smart Composeは,メール作成画面でユーザーがテキストを入力すると,AIが続きの文章を予測して提示するので,そのとおりに入力すれば文章を考える手間が省けるという機能だ。Gmailでは,受信メールの内容から返信用の一文を自動で作成する「スマートリプライ」という機能がすでにあるが,Smart Composeは,入力中の文章をリアルタイムで推測して補完するという点で,より進化した機能と言えよう。

|

毎日50億枚もの写真がアップロードされているという「Google フォト」でも,AIは活用しているという。

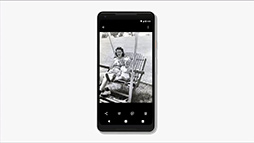

Googleフォトにおける新しいAI機能では,ユーザーの行動予測を利用して,写真に対する操作を提案するというものを実装するそうだ。たとえば,露出アンダーとAIが判定した写真を表示すると,露出補正を促す表示が出て,1タップで補正を行えるという。ほかにも,被写体を強調するために背景の色だけを白黒化したり,逆に白黒写真ではカラーにしたりといった補正の提案を行うそうだ。

|

|

|

|

紙の印刷物を撮影した写真に対しては,台形補正をしたうえで,PDFに1タップで変換するといった機能も提供するという。これらの画像認識や補正処理にも,GoogleのAIが使われているのである。

|

|

Googleアシスタントは,より自然な対話ができるように

GoogleでAIを使ったサービスと言えば,音声アシスタント機能「Googleアシスタント」も忘れてはいけない。2016年のGoogle I/Oで発表された機能だが,スマートフォンやスマートスピーカーなど,すでに5億台もの対応端末があるそうだ。車載機器の分野でも,自動車メーカーなどの40のブランドでGoogleアシスタント対応機器が販売されているという。

そんなGoogleアシスタントには,アップデートで新たに6種類の声が追加されるとのこと。さらに2018年後半には,ミュージシャンのJohn Legend(ジョン・レジェンド)氏の声も加わるそうだ。ただし,基本的には英語版の話で,日本語版がどうなるかは分からない。

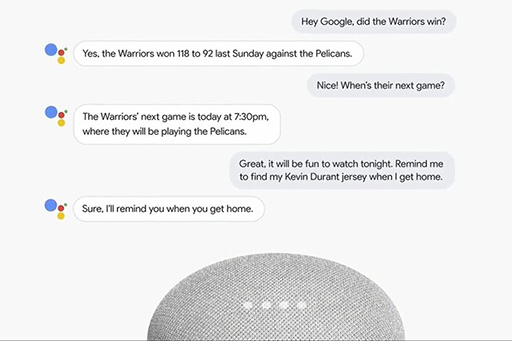

また,将来のGoogleアシスタントでは,より自然な会話が可能になるという。ここで言う自然な会話のポイントは,会話の継続性にある。現在のGoogleアシスタントは,1つの質問や命令をするごとに「OK, Google」とウェイクワードを言わなければならなかった。しかし,数週間以内に提供予定のアップデート後は,ウェイクワードが必要なのは最初の1回だけになり,それ以降はウェイクワードなしでユーザーとGoogleアシスタントの音声によるやり取りが行えるようになるという。

|

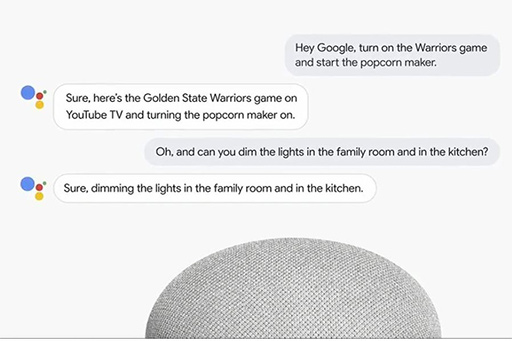

さらに,アップデート後のGoogleアシスタントでは,複数の命令を「and」でつないだ会話文に対応可能となるそうだ。たとえば,「(テレビで)スポーツの試合をつけて,コーヒーメーカーでコーヒーを作って」という文には,2つの命令が含まれている。Googleアシスタントは,この命令をそれぞれ認識し,テレビをつけてチャンネルを変え,コーヒーメーカーのスイッチをオンにするといった動作を,1度の命令で行えるようになるわけだ。

|

|

基調講演で披露されたデモはこういうものだ。まず,Googleアシスタントに対して,「火曜日の午前10時から12時の間にヘアカットの予約を取って」と指示する。すると,Googleアシスタントが自動でヘアサロンに電話をかけた。通話相手は,ヘアサロンのリアルな店員だ。英語での会話を翻訳してみるとこうなる。

- Googleアシスタント「12時に予約したい」

- 店員「12時は一杯です。近いのは13時15分です」

- Googleアシスタント「10時から12時で空いてませんか?」

- 店員「サービスに寄りますが」

- Googleアシスタント「ヘアカットだけです」

- 店員「それなら,10時から大丈夫です」

- Googleアシスタント「それで結構です」

- 店員「お名前は?」

- Googleアシスタント「リサです」

こんな会話を,実に自然な口調で,しかもGoogleアシスタントが途中に相づちを挟んだりしながら行うのだ。通話相手が,Googleアシスタントの言ったことを理解せず,間違った応答をしたときもきちんと訂正するといった具合で,会話は自然でなめらか。このデモを聞いた限りでは,AIが会話をしているとは気付かないだろう。この技術は「Google Duplex」と呼ばれているそうだ。

下に基調講演でのデモを記録したGoogle公式の動画を掲載しておくので,ぜひチェックしてほしい。

次期Android「Android P」は,さらにUIをシンプルに

|

最初のAndroid搭載スマートフォンが発表されてから10年目を迎えたAndroid OSの最新版となる「Android P」は,「コアにAIを統合した最初のAndroid OS」になるという。

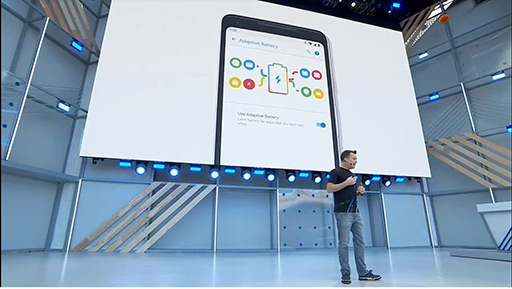

Android Pでは,機械学習を使ってユーザーの使用履歴から次の行動を予測し,最適な動作をするそうだ。たとえば,「Adaptive Battery」という新機能では,アプリの使用状況からその動作を判別し,CPUがアプリを起動するタイミングを減らしてバッテリー駆動時間を延ばせるという。

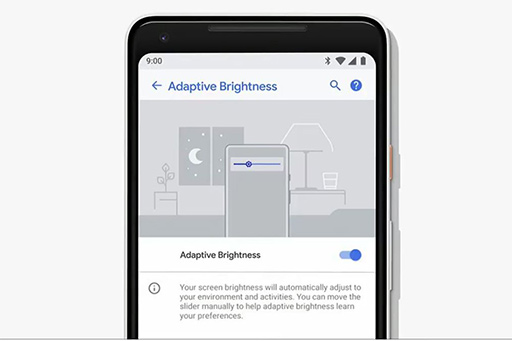

もう1つのバッテリーに関する新機能「Adaptive Brightness」は,環境光とユーザーのディスプレイの明るさ調整を学習して,個人に最適な明るさ設定を実現するそうだ。

|

|

|

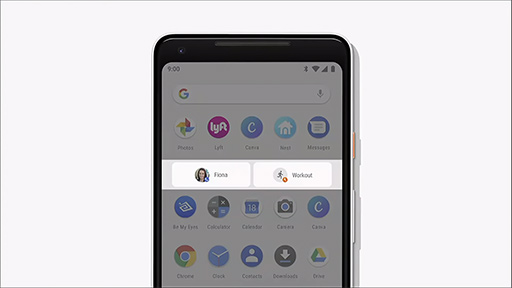

基調講演でのデモでは,ドロワー上に並んだ使用頻度の高いアプリの下に,「Fionaに電話する」「ワークアウト(トレーニング)を開始する」という2つのアクションが表示されていた。これが,ユーザーの使用履歴を学習して予測したものだ。

|

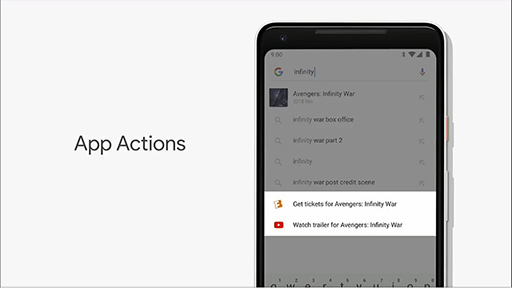

App Actionsが提案するアクションは,サービス開発者側が作成する。このアクションはGoogle検索だけでなく,ほかのサービス上でも動作し,たとえば映画「Infinity War」を検索しようとすると,チケットアプリで映画チケットを購入するリンクが表示される。

|

さらに「Slices API」という機能を使うと,検索結果から,アプリが指定した機能へ直接アクセスできるようになるそうだ。たとえば,Google検索でアプリ名を検索すると,端末内のアプリを検索するだけでなく,そこからさらにアプリの機能に対するリンクが表示され,使いたい機能を素早く利用できるようになる。

基調講演のデモでは,ライドシェアサービス「Lyft」を検索すると,アプリに加えて「自宅へ送迎」を提示するといった具合だ。また,Google検索で「Hawaii」(ハワイ)を検索すると,Googleフォトにあるハワイ旅行の写真を検索結果内にサムネイルで表示する様子も披露された。

|

|

App ActionsとSlicesは,2018年6月から,早期アクセスとして開発者が利用可能になるそうだ。実際にユーザーがその恩恵を受けられるようになるのは,もう少し先になるだろう。

AI関連以外の細かい改良点もたくさんある。

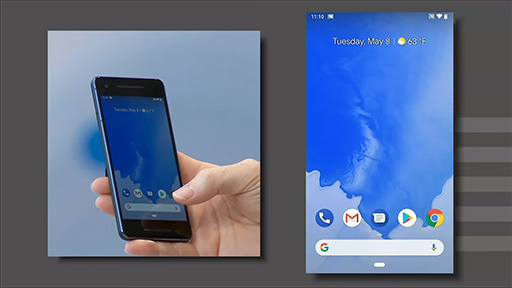

たとえば,Android Pでは,画面上のホームボタンが横長のバー形状に変わっている。

|

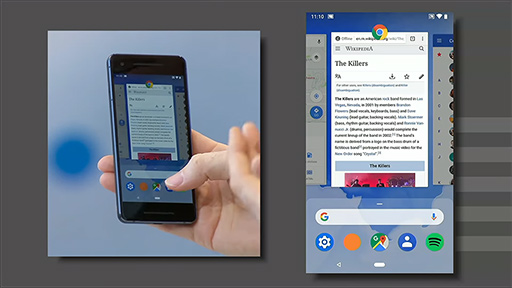

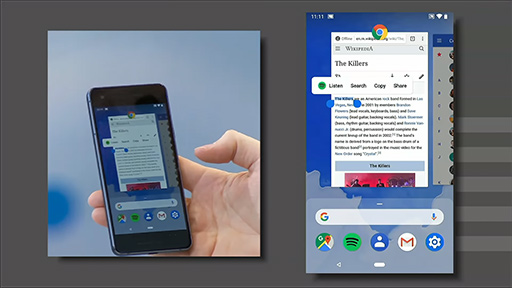

また,画面下側から上に向かってスワイプすると,アプリの履歴(オーバービュー)が大きく表示されて,左右のスワイプで切り替えられるようになった。バー型のホームボタンを左右にスワイプすると,アプリ履歴を素早く切り替えることも可能だ。オーバービュー状態のアプリ上で,テキストを選択してコピーするといった操作も可能になる。

|

|

そのほかに,画面の回転機能に改良が加わった。スマートフォンを回転すると,ホームボタンが置かれるナビゲーションバーの領域に回転アイコンが表示され,それをタッチとアプリの画面も回転するようになる。任意のアプリだけ,スマートフォンの向きに合わせて回転させたいというときに便利そうだ。

|

|

|

使いやすさを追求した改良に,AIベースのサービスを加えることで,より使いやすいOSを目指したのがAndroid Pと言えそうだ。

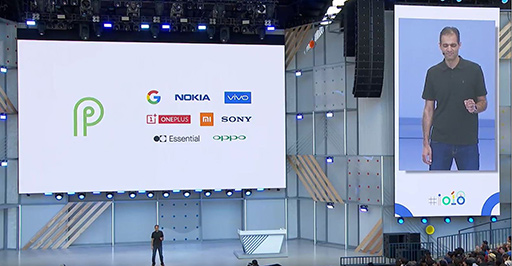

なお,Android P Betaは,Google純正のスマートフォン「Pixel」に加えて,

|

Google純正アプリの改良点

最後に,Google純正アプリの改良についても,簡単に説明していこう。

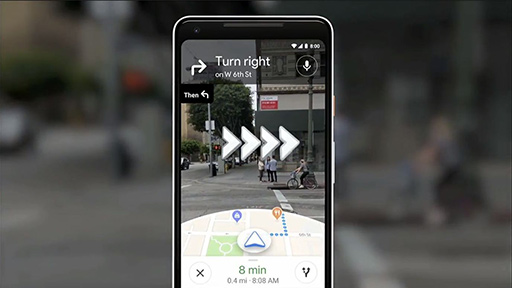

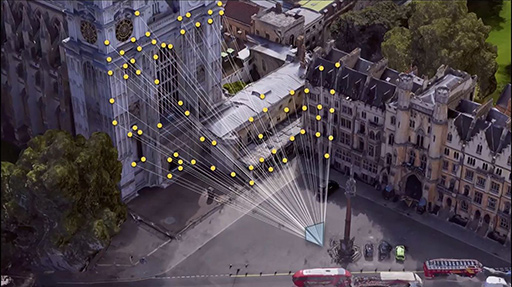

まず「Googleマップ」に,ARを活用したルート表示機能が加わる。これは,スマートフォンのカメラを起動して周囲の風景を写すと,目的地がどちらの方向か,カメラを通してみた風景の上に重ねて表示するというもの。単にGPS情報とコンパスだけで方向を判定しているのではなく,カメラに写った周囲の建物を認識して,正しい方向を割り出すので,より正確に現在位置と正しい方向が分かるわけだ

ちなみに,Googleではこの機能を,GPS(Global Positioning System)に対して「VPS」(Visual Positioning System)と呼んでいる。

|

|

|

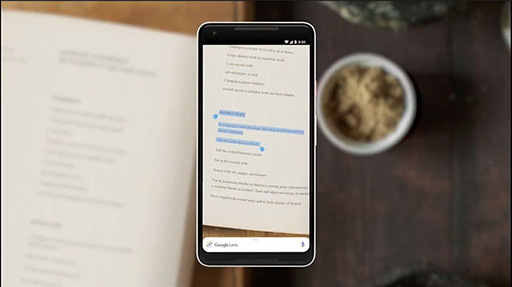

また,Googleレンズの新機能「Smart Text Selection」では,文字をカメラで写すと,それを文字認識してテキストに変換し,そのテキストをアプリで扱えるようになるという。たとえば,海外のレストランで英文のメニューを撮影すると,画面上で文字を選択できるようになるので,選択した文字でGoogle検索を行うということが可能になるわけだ。

|

GoogleのAIによるサービスは,これまでのAndroidにも存在していたが,それをさらに進化させて,実利用環境にうまく落とし込んできたというのが,Android Pとなるようだ。Googleアシスタントの自然な音声対話は,技術的なブレークスルーと感じるレベルだし,「世界を認識する」というGoogleレンズやGoogleマップのVPSも,実際に登場するのが楽しみな機能と言えるのではないだろうか。

- この記事のURL: