ニュース

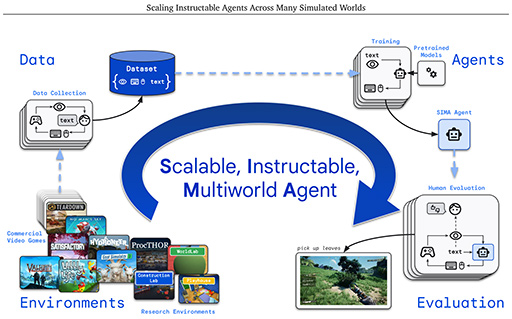

言葉で指示すると,指示どおりにゲームをプレイするAI「SIMA」。GoogleがAI研究の最新成果を明らかに

SIMAは,映像を見ながらキーボードとマウスを使い,「No Man's Sky」や「Valheim」「Goat Simulator 3」といった9種類のゲームをプレイしてみせたという。

|

Googleや,その傘下のAI研究開発企業であるDeepMind Technologiesは,これまでもゲームをプレイするAIを研究してきた。たとえば2020年には,古のゲーム機である「Atari 2600」でプレイできる57タイトルのゲームで学習した「Agent57」というAIを発表したこともある(関連リンク)。

今回のSIMAも,そうした過去のゲームをプレイするAI研究の流れをくむものだ。映像面はもちろん,内容も大幅に複雑な現行のゲームタイトルを対象としたのである。ただ,研究の目的自体は,ゲームに特化しているわけではない。Googleが公開した論文によると,SIMAは,自然言語処理の手法である「大規模言語モデル」と,現実世界を結びつける試みのひとつとして行われた研究であるという。

「ChatGPT」やGoogleの「Gemini」といった自然な言語で答えを返すAIチャットボットが実現するなど,大規模言語モデルは大きな成功を収めている。だが,たとえば大規模言語モデルを搭載して,人間の言葉で柔軟に指示でき,指示を解釈して動作するロボットが実用化されているかといえば,そうではない。いまのところAIは,大規模言語モデルによって言葉を理解できるようになったものの,現実の世界を認識して行動するといったレベルには到達していないからだ。

SIMAプロジェクトは,現実の世界を認識して行動できるAIを目指す研究の第一歩として行われている。現実世界の代わりを務めるのが,ゲームというわけだ。SIMAプロジェクトでは,AIに対して言葉で指示してゲーム中のタスクを実行させるという試みを行っている。

実際に使用されたゲームは冒頭で触れたNo Man's Skyなどのほか,「Satisfactory」や「Space Engineer」,「Teardown」など9タイトルとのこと。SIMAは,画面を見ながらキーボードとマウスを使い(※実物を動かすのではなく,操作に相当する出力をPCに送り込む),ゲームをプレイするという人間と同じ条件が与えられている。つまり,AIだからといって,ゲームのソースコードを見たり,ゲームプログラムの内部にアクセスしたりはしていないわけだ。SIMAには人間と同じ視覚が与えられているほか,OCRを内蔵しており,画面上の文字情報も読み取れる。

SIMAの学習には,主に2つの方法が使われている。ひとつは,まず人間がゲームをプレイして,その様子を映像で再生しながら,言葉で説明するというもの。SIMAがその様子を見て学習するわけだ。

もうひとつは,2人の人間でゲームをプレイするのだが,1人は言葉で指示して,もう1人が指示を実行している様子を,SIMAに見せて学習させた。

|

このような方法で学習したうえで,SIMAに対して言葉で約600のゲーム内タスクを行わせて,成功率を調べたそうだ。するとSIMAは,言葉の指示に従って人間に近いゲームプレイを行えるようになったという。たとえば,SIMAに「木材を集めろ」と指示すれば,そのとおりにプレイする程度の能力を実現できたのだ。

とはいっても,人間と同じレベルには程遠い。具体的には,人間ならば60%の成功率が得られるタスクに対して,SIMAは34%の成功率しか得ていないという。SIMAが苦手なのは,より抽象的だったり複雑だったりするタスクとのこと。たとえば,「はしごを登れ」といった具体的なタスクなら成功率が高いが,「採掘ビームを再充電しろ」というような入り組んだ指示だと,不必要な動作をしたり,関係ない動作をしたりすることもあるそうだ。まだまだ学習の途中,といったところだろうか。

冒頭で述べたとおり,SIMAプロジェクトは大規模言語モデルを現実世界に結びつけることを目標として行われた研究で,この成果が実際のゲームに直接的に使われるわけではない。ただ,たとえば言葉で指示できるボットとCo-opプレイができるようになる,といった未来はありえそうだ。SIMAには「人間と同じ条件でプレイする」という縛りがあったが,ゲームに登場するボットならそのような縛りはない。より賢くタスクを実行してくれるゲーム中の相棒的存在ならば,むしろSIMAの目指す先よりも,楽に実現できるだろう。そんなゲームの登場を待ちたい。

- この記事のURL: