イベント

Live2Dが描くキャラクタービジネスの未来。「alive Live2D Creators Conference 2015」レポート

|

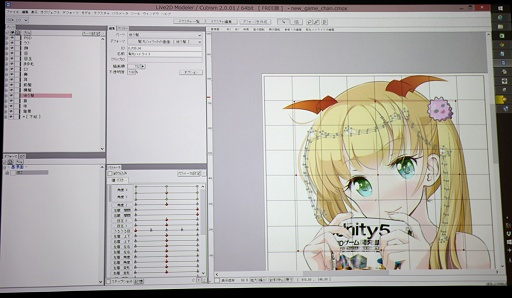

Live2Dといえば,2D画像をあたかも3Dオブジェクトであるかのようにアニメーションさせるミドルウェアとして知られているが,本イベントは,Live2Dを使用するクリエイターのための総合イベントだ。Live2D Creative Awardの発表や数々の事例,次世代製品「Live2D Euclid」を含むLive2Dの最新情報などがまとめて公開された。ここでは最新情報とゲーム寄りの話題を拾ってイベントの概要を紹介してみたい。

|

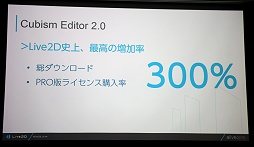

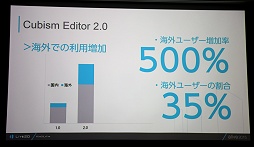

2013年に,前バージョンであるLive2D VectorからLive2D Cubismに変わって,機能と操作性が格段に上がり,Cubism 2.0が発表された昨年は過去最高のユーザー数の伸びを示したとのこと。採用事例は数多く,今後も続々とタイトルが登場するという。

|

|

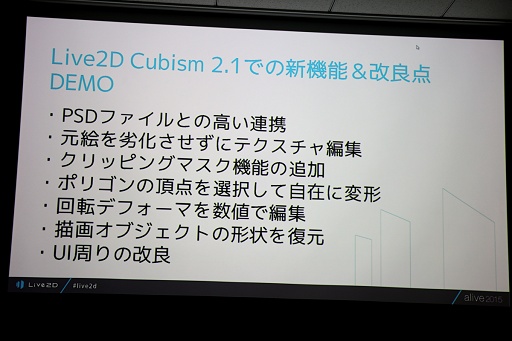

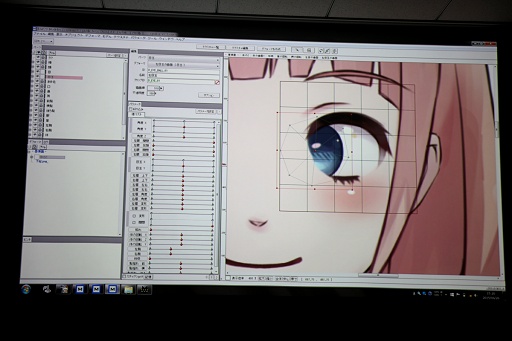

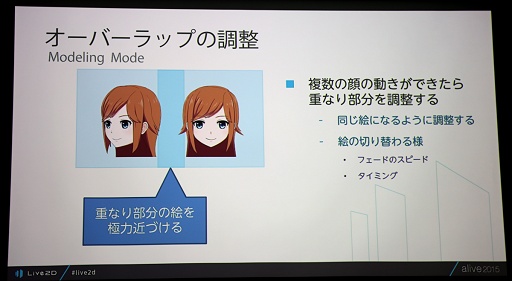

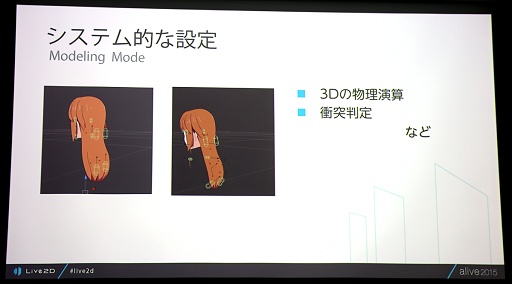

現在β版が公開されている最新のCubism 2.1では,30種以上の改良が加えられたとのことだが,そのうちの主なものが紹介された。曰く,Live2D上でいろいろいじっても画質が劣化しない,目や口の開け閉めでマスク用のオブジェクトが不要になるなど,使い勝手を大きく向上させるものとなるようだ。

|

|

|

|

|

まず,進捗だが,開発は順調とはいうものの,まだ現状ではリリース日などが出せる段階ではないようだ。パブリックなβ公開は少なくとも今年中では難しいとのことだが,秋には限定された法人を対象としたクローズドβテストが行われる模様だ。

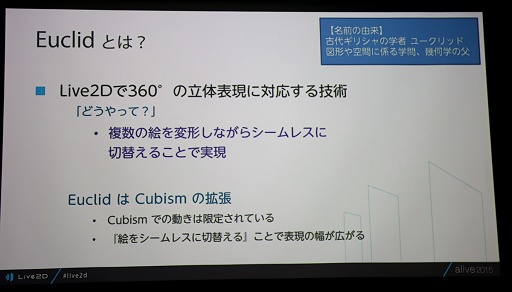

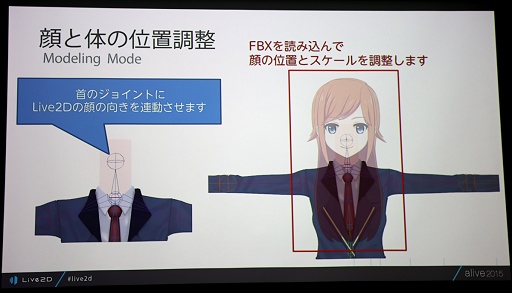

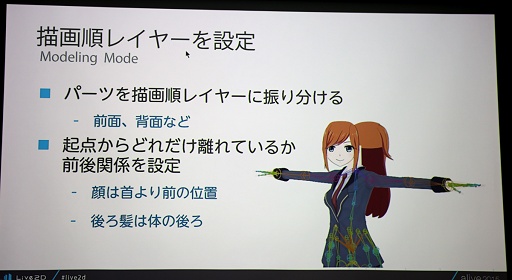

Euclidは,従来のLive2Dで行っていた,原画を立体的に処理する方法を推し進めて,複数の原画を切り替えて,つなぎの部分をうまく処理することにより,360度の回転を実現する技術だ。大きな動きが発生する身体部分は3Dモデリングで処理し,とくに気になる頭部のみをEuclidで処理して合成する仕様となっている。

|

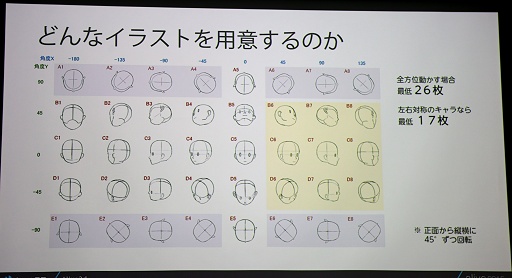

気になるのは,どんなデータを用意してどう作業するのかだが,今回はそのあたりの情報が公開された。まず,データだが,フルスペックで動かす場合は26枚の原画が必要となるという。左右対称の場合は17枚,上下方向を省略すればさらに削減できる。

|

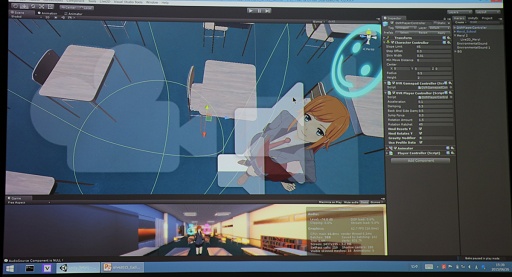

会場で公開されていたEuclidによるVRデモは,6枚の原画によって構成されたものだとのこと。上下方向は対応したデータがないのだが,エディタ(公開されていたのはUnity Editor上)でぐるぐる上下に動かしてみても,それほど不自然ではない絵は出ていた。よほど動きが大きくなければ水平方向のデータだけでも十分なのかもしれない。

|

|

|

現状では3Dモデリングよりもデータ量が大きくなってしまうことなどもあり,データ量については今後のテクスチャ圧縮技術などに期待がかかっていた。

今後は,ペイントツールを組み込んだり,Mayaや3ds Max,Unreal Engine,After Effectsなどとの連携も取れるようにしたいと,稲田氏。一方で中城氏は,まだ開発中ということもあって,クローズドβテストの段階では多くの困難も予想されているが,正式リリース時には描きたい通りに描き,動かしたい通りに動く夢のツールに仕上げたいと語っていた。

|

|

|

|

イベントでは,Live2Dを使った作品コンテストの結果発表と作品の紹介も行われた。グランプリを受賞した「Nekomimi Maid」は韓国のkutataさんによる作品で,多数のオブジェクトが動く圧巻の一品だ。審査員からはアングルが素晴らしいと絶賛の声が上がっていた。kutataさんは韓国でLive2Dを使ったゲームを開発しているとのことで,Unite 2015 SeoulではUnityとLive2Dによるゲーム開発で講演も行ったという。日本でもプレイできるアプリとしては「ポーションメーカー」が公開されている。

|

個人的に興味深かった作品としては,Unityイノベーティブ賞を受賞したnoshipuさんによる「ユニティちゃんとしゃべれるアプリ『UniTalk』」があった。その名のとおり,Unityちゃんと会話できるアプリで,NTTドコモが公開している知識Q&A APIや雑談対話APIが使用されているようだ。デモ画面では「富士山の高さは?」のような質問をしていた。しりとりもできるそうだ。ん? 最近どこかで似たようなものを見たような……やっぱりそういうことなんだろうか。

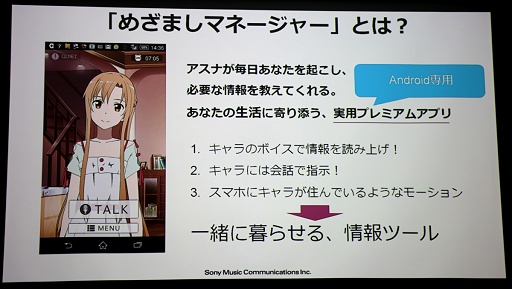

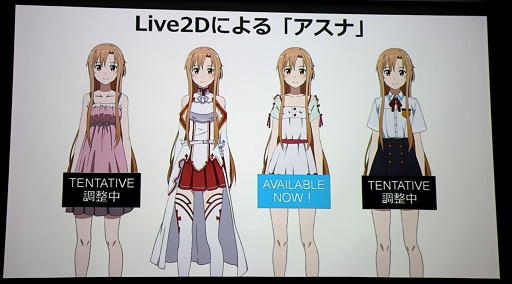

こういったAIアプリも個人で作れる時代になってきているわけだが,それをさらに進めたようなもののLive2Dによる実装も紹介されていた。ソニー・ミュージックコミュニケーションズによる「めざましマネージャー アスナ」だ。

|

これは,毎朝「ソードアートオンライン」のヒロインであるアスナが起こしてくれるというアプリなのだが,講演を行ったプランナーの松平恒幸氏は「目覚まし時計を作りたかったわけではない」と語る。目覚ましは一機能にすぎず,キャラクターの声で情報を読み上げることができ,音声でキャラクターと会話できる「一緒に暮らせる情報ツール」がその実体だという。

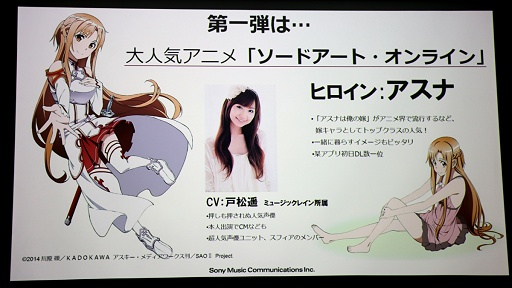

昨今では多くのものに音声ガイダンス機能が付いており,対話+αが今後のデジタル関連機器で標準的なインタフェースとなると松平氏は語っていた。氏は,遠からず,すべてのものがしゃべりだす世の中となり,そうなったときの差別化要因として個人個人の「好み」が問題となると予見したという。好ましいパーソナリティを持ったキャラクターを押さえることが重要になるというわけだ。そしてプロジェクトの第1弾で選ばれたのが,嫁キャラとして突出した人気を誇るというSAOのアスナだというわけである。

|

|

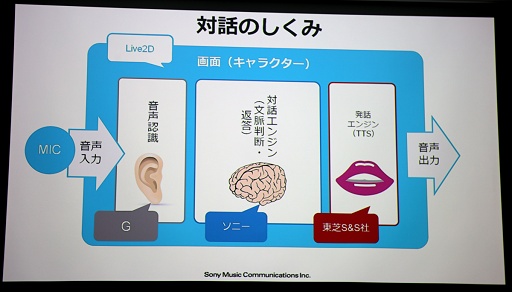

アプリの表示部分は当然ながらLive2Dが担当しているわけだが,これはもはやアニメ絵を自然に動かせて当たり前なためかあまり解説は行われなかった(頭蓋骨の形や肩のラインなどで無茶苦茶細かい注文を出していたそうだが)。重点が置かれたのは音声による対話機能についてで,その仕組みが簡単に紹介されていた。

対話を実現するための処理には,人間の「耳」にあたる音声認識機能,その音声を解析して返答を作成する「脳」にあたる対話エンジン,そして作成されたテキストを音声にして出力する発話エンジンが必要になると松平氏は説明していた。

|

まず,ユーザーの音声を認識する部分には,世界的な大企業である「G社」の技術が使われているという。なぜか具体的には語られなかったが,不特定話者に対する音声認識エンジンを公開している某社のものと思われる。ちなみに,現在めざましマネージャーが提供されているのはAndoroid端末だけである。

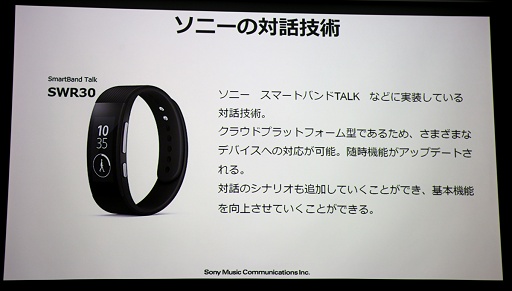

脳に当たる対話エンジンには,グループ会社であるソニーが開発していたエンジンが使われているという。対話エンジンにもいろいろタイプがあるそうなのだが,ソニー製品は文脈を解析して命令を出すのに適した構成で,今回のプロジェクトに適していたとのこと。

|

最後にテキストを声で出力する部分は,東芝セミコンダクター&ストレージによるエンジンが使われているとのこと。この部分を松平氏は「今最も熱い技術」と語り,デモ音声でその凄さを示していた。それはWebから取得した情報をそのままエンジンに渡してアスナ(戸松 遥さん)の声で読み上げるというもので,合成音声とは思えないような自然な発声が行われていたのにちょっと驚いた。

映像のないデモだったので音声だけで申し訳ないのだが,録音から切り出してみたので確認してみてほしい。音声で受け答えするアスナのセリフは,いずれも「収録音声ではない」合成音声とのこと。最近ではここまでできるようになっているのか。

これらの先端技術が投入されてできたのがめざましマネージャーアスナというわけだ。このようなことができると,今後のキャラクタービジネスも大きく変わってくるだろう。

アニメやマンガのキャラクターが,Euclidで原画そのままに動き出し,VRで実在感を加え,キャラクターそのままの声で,AIによるキャラクターの個性と会話できる。そんなことがすでに実現可能な世の中もやってくる。当然ゲームにも関連してくる分野であり,今後の動向が注目されるところだ。

|

Live2D公式サイト

- 関連タイトル:

Live2D

Live2D

- この記事のURL: