イベント

AI技術をアプリに落とし込むGoogle。次期AndroidやVR HMD「Daydream」の最新情報も出たGoogle I/O基調講演レポート

|

5月17日の午前中に行われた基調講演は,多岐にわたる分野の発表を2時間に詰め込んで行うという,非常に密度の濃いものだったが,その主役はやはり人工知能(以下,AI)分野だ。それを分かりやすく示したのが,講演の冒頭に登壇したGoogleのCEOであるSundar Pichai(サンダー・ピチャイ)氏である。氏は,「これまでのGoogleは『Mobile first』(モバイル第一主義)の企業だったが,これからは『AI first』(AI第一主義)の企業になる」という言葉で,GoogleにとってAIがいかに重要であるかをアピールしていた。

|

|

2時間もの講演内容すべては紹介しきれないし,そもそも日本のゲーマーに関わりのない話題も少なくない。そこで本稿では,AI分野とその応用製品,次期Android OS「Android O」,VRプラットフォーム「Daydream」などの話題に焦点を絞ってレポートしたい。

AIは研究からアプリでの実用へ進む

Google独自のコンピュータ「Cloud TPU」も披露

まずはメインテーマであるAI分野の話題から。このパートはCEOのPichai氏が自ら担当するなど,力の入れようが窺える。

基調講演で出てくるAIの話というと,技術的な話題や概念的な話題が多いものだが,Pichai氏は今回,AI技術の具体的な応用事例から話を始めた。

たとえば,スマートフォンのカメラを使った写真撮影なら,AIによるディープラーニング(深層学習)の成果を応用して,暗いところで撮影した画像からノイズを取り除くといった修正を自動で行うといったことが可能であるという。さらに近い将来には,「金網の向こう側にいる人物を撮影した写真から,金網を取り除くといった機能を搭載するだろう」と,Pichai氏は述べている。

|

|

|

|

|

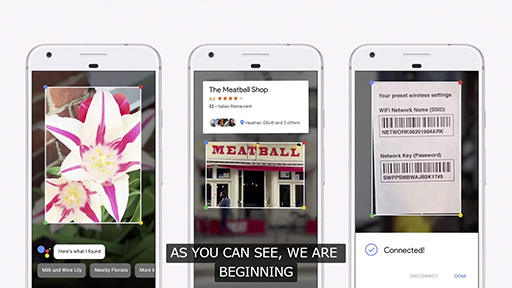

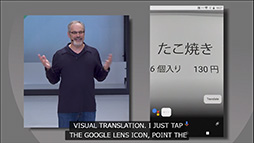

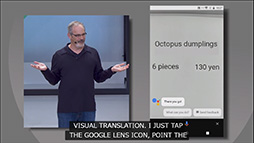

これは,スマートフォンのカメラ映像や写真データを認識して,何が写っているのかを判断し,内容に応じた適切な処理を行うというもの。たとえば,花を写せば,それが何の花であるのかを説明する。街角で店を撮影すれば,店舗情報を表示するといった具合だ。無線LANルーターのSSIDやパスワードを印刷したシールを撮影することで,自動的に無線LANの設定を行い,ネットワークに接続するといった処理も可能であるという。

|

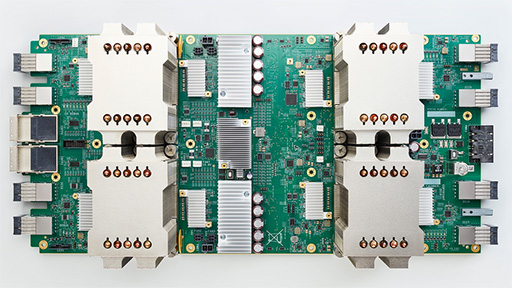

こうしたGoogleのAI技術を支えるものとして,Pichai氏は,同社が開発したディープラーニング専用コンピュータ「Google Cloud TPU」(以下,Cloud TPU)を紹介した。

Cloud TPUは,Google製の第2世代TPU(Tensor Processing Unit)を4基搭載したボード型コンピュータだ。Cloud TPUは1台で,最大180TOPS(Trillion OPS)の処理性能を有するという。

|

Cloud TPU専用の相互接続用ネットワークインタフェースを備えており,64台のCloud TPUをメッシュ状に接続した「TPU Pod」を,Googleはすでに構築しているそうだ。既存のGPUを32基使ったシステムでも丸1日かかっていた機械学習が,TPU Pod内にあるCloud TPUのうち,8基分を使うだけで半日で終わらせることが可能になったという。

このCould TPUで構築したシステムは,「Google Compute Engine」というクラウドAIサービスとして,基調講演当日に外部からの利用できるようになるとPichai氏は述べていた。

ちなみにこのサービスでは,Cloud TPUだけでなく,汎用CPUや先週発表されたばかりのNVIDIA製最新GPU――「Tesla V100」のことと思われる――も利用できるそうだ。

|

|

|

|

|

|

|

Googleのスマートスピーカーが今夏に国内発売

日本での販売が行われていないので,存在自体を知らない人も少なくないと思うが,とくに米国で2015年頃から急速に普及し始めたデバイスに,いわゆる「スマートスピーカー」というものがある。スピーカーとは言うものの,サウンドを再生する機能よりも,声で話しかけて家庭内の機器を操作したり,声でクラウドサービスにアクセスして音声で情報を得たりといった機能で話題になっている機器だ。

この分野で先行しているのがAmazon.comである。同社のスマートスピーカー「Amazon Echo」は,音声認識API「Alexa」を外部のパートナー企業に公開したこともあって,急激に対応機器やサービスを増やしつつある。こうした機器で使う音声認識機能の裏で動いているのは,ここでもAIだ。

この動きをGoogleが指をくわえて見ているはずもなく,Google Assistantを利用するスマートスピーカー「Google Home」を世界市場で販売している。

|

|

|

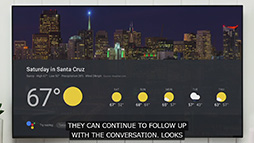

さらに今回の講演では,Google Homeに導入するさまざまな新機能も発表となった。とくに注目に値するのが,「Visual Response」と称する映像出力機能だろう。先述したとおり,スマートスピーカーは声で入力して,その結果を音声で出力するのが基本の機器だが,音声だけでなく映像でも出力できるようにしたのがVisual Responseである。

Visual Responseでは,Google Homeに声で「今日の天気は?」と話しかけると,ネットワーク経由でワイヤレスデバイス「Chromecast」を接続したテレビの画面に,周辺の天気を表示するといったことが可能だ。Google Homeに目的地までのルート検索を声で命じると,その結果をユーザーのスマートフォン上で示すなんてこともできるという。

|

|

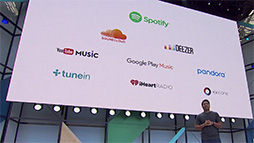

Google Homeはそのほかにも,北米を対象とした無料のハンズフリー通話機能や,音楽ストリーミングサービス「Spotify」との提携により,Spotifyの再生機能を無料で使えるといった機能強化を行うとのことだ。

国内での展開にも期待したい。

|

|

次期Android「Android O」の新機能は小粒?

|

その次期Android OSである「Android O」は,以前から開発者向けプレビュー版(いわゆるα版)が公開されていたが,Google I/Oにあわせてβ版の公開が始まった。2017年夏予定という正式リリースに向けた準備は,着々と進んでいるようだ。

基調講演で披露されたAndroid Oの新機能を簡単に説明していこう。

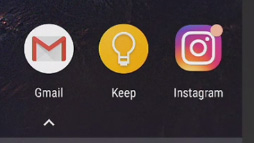

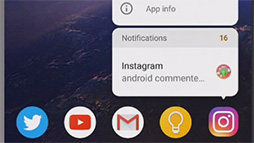

まずは「Notification Dot」。これは,ホーム画面に置いたアプリのショートカットアイコンに「点」が付いて,通知があることを示すものだ。通知領域を開くと概要を見られるのは,今までのAndroidと同じだが,Android Oからは,アイコンの長押しでも通知内容を表示できるようになったので,より直感的に操作できるようになったとも言える。

|

|

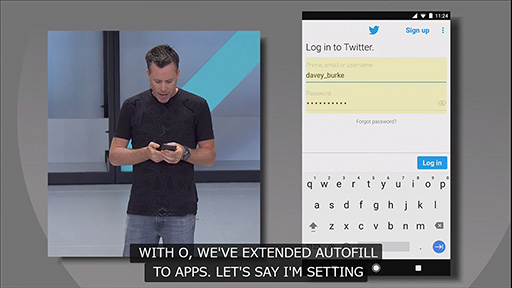

また,Androidアプリ上で,サービスへのログインに使うユーザー名やパスワードを自動的に入力する「Autofill with Google」という機能が加わる。基調講演でのデモでは,Twitterアプリでユーザー名,パスワードを自動入力していた。

|

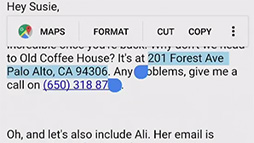

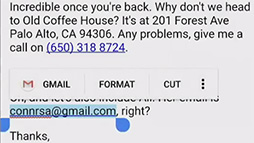

テキストの範囲選択にも,ちょっと便利そうな改良が加わるという。Android Oではディープラーニングの成果を生かして,タッチしたテキストから適切な部分を自動選択したうえで,テキストの内容を分析して,それに関連すると思われるアプリを提示する機能が実装されるとのことだ。

たとえば,メールの文面で住所の部分をタッチすると,住所部分だけを自動選択したうえで,「Maps」のような場所に関連するアプリを提示する。同様に,メールアドレスを選択すると,自動で「Gmail」が提示されるといった具合だ。

|

|

|

Android OS自体の最適化も進み,OSの起動にかかる時間が従来の半分程度になったそうだ。また,アプリのバックグラウンド実行に対する制御を改善して,従来よりもバッテリー消費を抑えることが可能になるという。

そのほかにもアプリ開発者向けの新要素として,Playストアで公開したアプリの状況や挙動などを調査する「Dashboard」の機能を強化した「Play Console Dashboards」が登場したり,Androidアプリの開発に用いるプログラミング言語として,JetBrainsが開発した「Kotlin」が正式に採用されたりといった話題が取り上げられている。

新興国向けの軽量Android「Android Go」

|

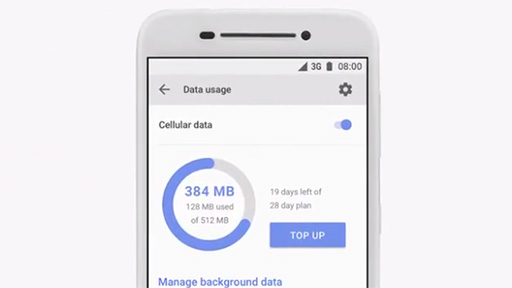

Android Goは,Android Oをベースとして,低スペックの端末でも動作するようにGoogleが最適化したOSである。容量1GB以下のメインメモリで動作することを前提としており,メインメモリ容量が512MBの端末でも動作可能であるという。

|

Googleが提供するAndroid Go向けアプリも,低スペックの端末に最適化したものとなるそうだ。

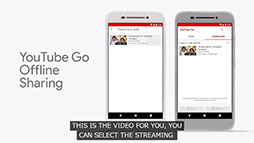

たとえば,Webブラウザの「Chrome」であれば,通信データ量を減らす「データセーバー」機能がデフォルトで有効になっており,通信データ量を削減できる。また,ビデオ再生アプリ「YouTube Go」では,ビットレートを減らしたビデオのダウンロードや,ダウンロードしたビデオをほかのAndroid Go端末と直接やり取りする機能を備えているそうだ。

新興国では,通信環境がよくない場所が多く,日本のスマートフォンユーザーが使っているような高画質のストリーミングビデオを扱うのは困難という事情を反映しているわけだ。

|

|

アプリ開発者に対しては,オフライン環境やメインメモリ容量の小さな端末に適したアプリを開発するために,Android Go用のソフトウェア開発キットも提供するとのこと。すでに「Facebook Lite」や「Skype Lite」,「Line Camera」といった軽量版アプリが用意されているようだ。

Android Goの正式リリースは,2018年の予定となっている。

|

対応スマートフォンやHMDを拡充する「Daydream」

最後に取り上げるのは,ゲーマーの注目も高そうなVR分野だ。

Googleは2016年のGoogle I/O基調講演で,AndroidベースのVRプラットフォームであるDaydream」を発表している。そして今回の基調講演では,対応ハードウェアに関する新発表が相次いだ。

|

|

現在,世界市場で販売中のDaydream対応VRヘッドマウントディスプレイ(以下,HMD)は,Google純正の「Daydream View」くらいだが,これは内部にハイエンドスマートフォンを填め込んで使うもので,PC用のVR HMDに比べればマシとはいえ,いささか手軽さに欠けるだろう。

そこで,スマートフォン相当の機能を内蔵した「スタンドアロン」型のDaydream対応VR HMDを,HTCとLenovoが2017年末にリリースすることが発表となった。

|

|

2社の製品がどのようなハードウェアになるのかは,まったく発表がないので分からない。ただ,GoogleとQualcommは,基調講演での発表にあわせて,Daydream対応のスタンドアロン型VR HMDを開発するための開発者向けリファレンスデザインキットに,Qualcommの最新SoC(System-on-a-Chip)である「Snapdragon 835」を採用することを発表した。

Snapdragon 835を採用した開発者向けVR HMD「VR Development Kit」(以下,VRDK)は,すでにリリース済みで,ゲーム開発者向けの展示がGDC 2017で行われたこともある。VRDKは,HMD前面に位置トラッキング用のステレオカメラを備えているのに加えて,手の動きを検出するためにLeap Motionのセンサーユニットも装備していた。

|

Daydream対応のスタンドアロン型VR HMDは,ステレオカメラを使ったGoogleの位置トラッキング技術「WorldSense」を採用するとのこと。HTCやLenovoのVR HMDにも,この技術が採用されると思われるが,Leap Motionを使ったハンドトラッキングが採用されるか否かは,現時点で情報がないので分からない。

|

基調講演では,2016年に登場したLenovo製スマートフォン「PHAB2 Pro」に続いて,今夏に国内でも発売予定のASUSTeK Computer製スマートフォン「ZenFone AR」が,Tangoに対応することが改めて告知された。

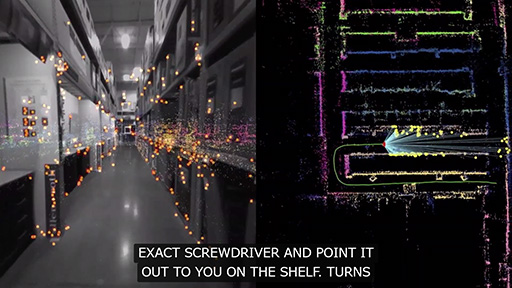

ソフトウェア面では,地図アプリのMapsにTango連携機能が加わるという。現実世界にある店舗の情報を取り込み,店内での位置検出や,商品がどこにあるかのナビゲーションが可能になるそうだ。ビデオで流れただけだが,アメリカのホームセンターチェーン「Lows」の店内でTango対応スマートフォンの外界認識機能を使って,店内を案内するというデモは,なかなか興味深いものだった。

|

|

基調講演の最後に再び登壇したPichai氏は,ディープラーニングを応用して求職情報の検索を行う新サービス「Google for Jobs」を紹介したうえで,GoogleはAI firstの企業に転身することを改めて宣言して講演を終えた。ゲーマーから見れば,AIとはあまり関係のない話題であるAndroid OやDaydreamのほうが気になるところだが,現在のGoogleがどこに軸足を置いているのは,覚えておいて損はないのではないだろうか。

- 関連タイトル:

Daydream

Daydream - この記事のURL: