ニュース

NVIDIAがHopperベースのデータセンタ向けGPU「H200」を発表。GPUコアはそのままだが,「HBM3e」メモリ採用により高性能化

|

H200は「Hopper」アーキテクチャをベースとしたGPUで,現行の「NVIDIA H100」と演算性能は同等であるが,グラフィックスメモリとして新開発の広帯域メモリ「HBM3e」を採用したことが特徴だ。HBM3e採用によって,メモリバス帯域幅はH100の3.35TB/sから,4.8TB/sへと,約1.4倍強に拡大している。

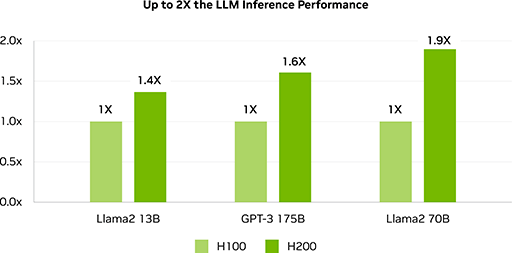

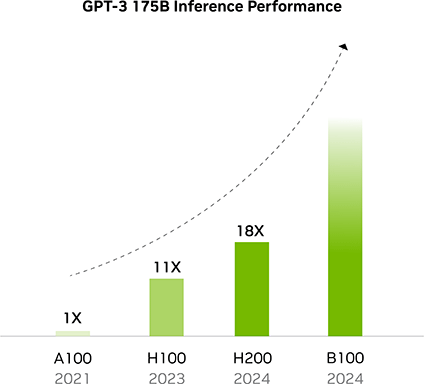

HBM3e搭載に合わせて,メモリ容量もH100の80GBから,141GBまで増えた。メモリバス帯域幅と容量の拡大によって,とくにメモリ負荷が高い大規模言語モデルの推論やトレーニングタスクの高速化が期待できるだろう。NVIDIAはH200の大規模言語モデルにおける推論性能が,H100に比べて最大約2倍に引き上げられているというグラフを示して,その性能をアピールしている。

|

|

今回,発表となったH200は,NVIDIA独自の拡張基板規格「SXM」対応の基板に実装されている。NVIDIAは,H200を搭載したAI処理向けスーパーコンピュータのHGX 200として出荷するほか,2024年第2四半期には,システムメーカーやクラウドプロバイダからも利用が可能になるとのことだ。大規模言語モデルのゲームへの応用もちらほらと出始めているので,その性能を加速させるH200の登場は,ゲーマーも頭の片隅に入れておくといいかもしれない。

- 関連タイトル:

Hopper(開発コードネーム)

Hopper(開発コードネーム) - この記事のURL: