ニュース

NVIDIA,データセンター向けGPU「A100 80GB」を発表。容量80GBの広帯域メモリ「HBM2e」を採用

|

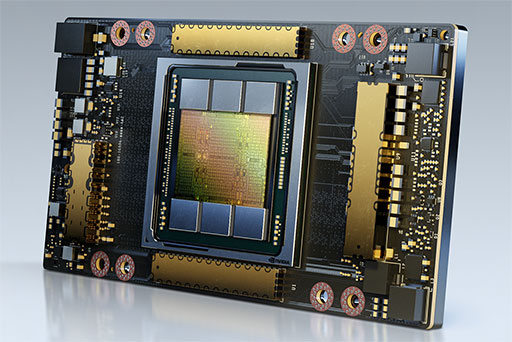

A100 80GBは,2020年5月に発表となったGPU「NVIDIA A100」(以下,A100)の高性能版という位置付けになる。A100は,AmpereアーキテクチャベースのGPUコアとグラフィックスメモリに容量40GBの広帯域メモリ「HBM2」(High Bandwidth Memory 2)を採用していた。一方,今回発表となったA100 80GBは,グラフィックスメモリに,第3世代の広帯域メモリ「HBM2e」(High Bandwidth Memory 2e)を採用したのが見どころだ。HBM2eは,HBM2をベースとして,容量とメモリバス帯域幅を引き上げた製品となる。

HBM2eの採用により,A100 80GBでは,従来製品の2倍となる容量80GBのグラフィックスメモリを搭載した。また,2TB/sを超えるメモリバス帯域幅を実現したという。

|

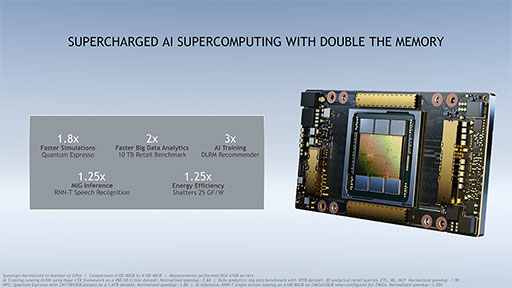

NVIDIAによると,メモリバス帯域幅の向上により,シミュレーションや各種AIの処理において,A100 80GBはA100と比べて約1.25倍から3倍の性能を実現したそうだ。ただし,現時点ではGPUの動作クロックなどのスペックが明かされていないので,これらの性能向上が,メモリバス帯域幅によるものだけなのかは分からない。

|

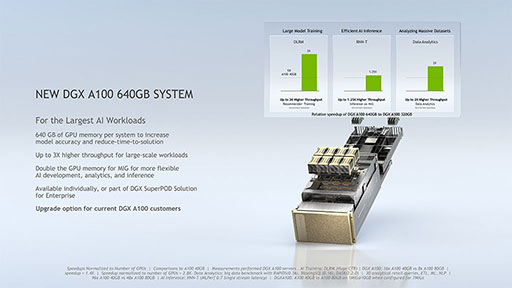

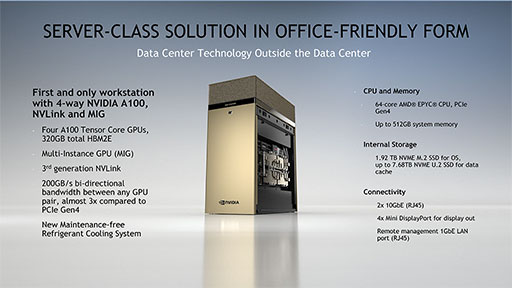

なお,NVIDIA A100 80GBの発表に伴い,同製品を最大8基搭載するスーパーコンピュータ「DGX A100 640GB」や,同製品を最大4基搭載できるワークステーション「DGX Station A100」も発表となった。

|

中でもDGX Station A100は,既存の「DGX Station」から,GPUがA100 80GBに変更となるだけでなく,搭載CPUがIntelの「Xeon」から,AMDの「EPYC」へと切り替わったのがポイントだ。

NVIDIAによると,PCI Express 4.0のサポートといった要素を含めて,総合的な判断からEPYCを採用したとのことだった。

|

A100 80GBは,ゲーマーには縁遠い製品であるのだが,最新世代の広帯域メモリであるHBM2eと,それを採用した実製品が登場したというあたりは,記憶の隅にとどめておいてもいいかもしれない。

NVIDIA日本語公式Webサイト

世界で最も強力なAIスーパーコンピューティング用GPUを

大幅に強化

システムプロバイダーのトップ企業であるAtos、Dell Technologies、

富士通、GIGABYTE、Hewlett Packard Enterprise、Inspur、

Quanta、Supermicroが、NVIDIA A100システムを世界の産業に提供予定

2020年11月16日、カリフォルニア州サンタクララ −SC 20− NVIDIAはこのたび、NVIDIA HGX AIスーパーコンピューティング プラットフォームを支える最新のイノベーションであるNVIDIA

HBM2eテクノロジを搭載した新しいA100は、A100 40GBの高帯域幅メモリを80GBに倍増し、毎秒2テラバイトのメモリ帯域幅を実現しています。これによってデータの読み込みが速くなるため、研究者はアプリケーションをさらに高速化し、最大規模のモデルやデータセットに挑戦することができます。

NVIDIA のディープラーニング応用研究担当バイス プレジデントのブライアン カタンザーロ (Bryan Catanzaro) は次のように述べています。

「HPCやAIの研究で最新の成果を上げるには、非常に大きなモデルを構築しなければなりませんが、それにはかつてないほど多くのメモリ容量と帯域幅が必要です。A100 80GB GPUは半年前に発表された先代の2倍のメモリを備え、毎秒2テラバイトの壁を破っており、研究者は世界で最も重要な科学やビッグデータの課題に取り組めます」

NVIDIA A100 80GB GPU は、NVIDIA DGXTM A100 システムと、今回同時に発表され、この四半期に発売予定の NVIDIA DGX Station TM A100 システムで利用できます。

システム プロバイダーのトップ企業である Atos、Dell Tech

大量のデータを必要とするワークロードの加速

A100 40GBと比較すると、A100 80GBは、膨大なデータメモリを必要とする幅広いアプリケーションに最適です。

AIトレーニングの場合、DLRMのようなレコメンダーシステムモデルには、何十億人ものユーザーと何億もの製品を表す巨大なテーブルがあります。A100 80GBは3倍まで高速化できるため、企業はこのようなモデルを素早く再トレーニングして、非常に正確なレコメンデーションを実現できます。

また、A100 80GBによって、たとえば超人的なテキスト生成能力を持つ自然言語処理モデルであるGPT-2のような最大級のモデルを、さらに多くのパラメーターを使ってトレーニングすることが、1台のHGX搭載サーバーだけで可能になります。実装に時間がかかり、複数ノードでの実行が遅くなりがちな、データまたはモデルの並列アーキテクチャの必要がなくなります。

A100は、マルチインスタンスGPU(MIG)テクノロジによって最大 7つのGPUインスタンスに分割することができ、各インスタンスはそれぞれ10GBのメモリを持ちます。これにより、ハードウェアを安全に分離し、より小規模な種々のワークロードのためにGPUの使用効率を最大化することができます。RNN-Tのような自動音声認識モデルのAI推論では、1つのA100 80GB MIGインスタンスではるかに大きなバッチサイズを提供でき、稼働時に1.25倍を超える推論のスループットを実現します。

小売業向けのテラバイトサイズのビッグデータ分析ベンチマークにおいて、A100 80GBはパフォーマンスを最大2倍に向上させ、最大規模のデータセットで迅速な洞察を提供するための理想的なプラットフォームとなっています。データが動的に更新されるため、企業はリアルタイムで重要な意思決定を行うことができます。

気象予報や量子化学のような科学への応用では、A100 80GBは大幅な高速化を実現できます。材料シミュレーションのQuantum

理化学研究所計算科学研究センターの松岡聡 センター長のは次のように述べています。

「スーパーコンピューティングのアプリケーションでハイパフォーマンスを実現するには、高速で豊富なメモリの帯域幅と容量が欠かせません。HBM2e GPUメモリを80GB備えるNVIDIA A100は、世界最速の毎秒2テラバイトの帯域幅を実現しており、アプリケーション パフォーマンスを大幅に引き上げることができるでしょう」

A100 80GBの主な特徴

A100 80GBには、NVIDIA Ampereアーキテクチャの画期的な特徴が多く含まれます。

第3世代 Tensorコア:新しいフォーマットのTF32で、前世代のVoltaの最大20倍のAIスループットを実現する他、HPC向けのFP64は2.5倍、AI推論向けのINT8は20倍であり、BF16データ フォーマットにも対応。

より大きく、より速い HBM2e GPUメモリ:メモリ容量が2倍に増え、業界で初めて毎秒2TBを超えるメモリ帯域幅を実現。

MIG テクノロジ:分離されたインスタンスあたりのメモリが2倍となり、各10GBのMIGを7つまで提供。

構造化スパース性:スパースなモデルの推論で最大2倍の高速化を実現。

第3世代のNVLinkとNVSwitch:GPUからGPUへの帯域幅が前世代の相互接続テクノロジの2倍となり、データを大量に用いるワークロード向けに、GPUへのデータ転送を毎秒600GBに高速化。

NVIDIA HGX AI スーパーコンピューティング プラットフォーム

A100 80GB GPUは、NVIDIA HGX AIスーパーコンピューティングプラットフォームの重要な要素であり、NVIDIA GPU、NVIDIA NVLink、NVIDIA InfiniBandネットワーク、そして完全に最適化された NVIDIAのAIおよびHPCソフトウェア スタックの力をすべて結集して、最高のアプリケーション パフォーマンスを提供します。これにより、研究者や科学者は、HPC、データ分析、ディープラーニングのコンピューティング手法を組み合わせ、科学の進歩を推進することができます。

- 関連タイトル:

NVIDIA RTX,Quadro,Tesla

NVIDIA RTX,Quadro,Tesla

- この記事のURL:

Copyright(C)2010 NVIDIA Corporation